モンテカルロ積分 (2)

モンテカルロ積分(2014/7/28)のつづき。今回は、Rによるモンテカルロ法入門の例3.3と練習問題3.1のモンテカルロ積分の例を検証した。

例3.3

例3.3は簡単な積分の問題。

これも前回と同じように確率分布 p(x) が明示的にないため一様分布を追加する。積分区間が [0, 1] なので b - a = 1 となり無視できる。

実行結果は

scipy.integrate: 0.96520093605 モンテカルロ積分: 0.966150133367

練習問題3.1 正規・コーシー-ベイズ推定量の積分

練習問題3.1はもっと複雑な積分だ。どうやら正規・コーシー-ベイズ推定量と呼ばれるものらしい。何に使うのかはよくわからないけど・・・

これがなぜ正規・コーシー-ベイズ推定量と呼ばれるのか謎だったのだが、上の式を下の式のように変形すると正規分布とコーシー分布が出てくることがわかった。が突然現れるけど分子と分母でクリアされるので追加しても問題ない。

分子と分母に出てくる積分をモンテカルロ積分で計算してみる。分子と分母はほとんど同じ形なので分子だけ説明。この積分は二通りの方法でモンテカルロ積分が適用できることがわかる。

(1) コーシー分布をpとみなしてコーシー分布からサンプリングする場合

(2) 正規分布をpとみなして正規分布からサンプリングする場合

初めて一様分布以外からサンプリングするモンテカルロ積分の例が出てきた。両方のパターンで積分を計算し、結果を比較してみよう。ついでにscipy.integrateの結果も出してみた。

scipy.integrate: 3.43506155523 モンテカルロ積分(1): 3.4456557745 モンテカルロ積分(2): 3.43354612482

どちらの場合でもscipy.integrateとほぼ同じ結果が得られることがわかる。何回かやるたびに結果が変わるのだけれど正規分布の方がscipy.integrateの結果に近いことが多いようだ。コーシー分布は正規分布より裾野が広いため平均から外れたとんでもないサンプルが出てしまうことがあるからかな?特にサンプリング数Nが小さいときに違いが出てくる。どちらの分布からサンプリングした方がよいかの検証は次回やってみよう。

モンテカルロ積分

Pythonによるモンテカルロ法入門(2014/6/20)のつづき。3章のモンテカルロ積分について実験した。

モンテカルロ積分

モンテカルロ積分を使うと統計や機械学習で頻繁に出てくる期待値を求める積分が乱数生成で簡単に計算できる。期待値を求める積分とは下の形をした積分。

ここで、f(x) は任意の関数、p(x) は確率分布を表す。たとえば、のときは確率変数Xの平均、

のときは確率変数Xの分散だった。実際、f(x) は上の二つに限らずどんな関数でもよい。

モンテカルロ積分のアルゴリズムは以下のとおり。確率分布から生成したサンプルの平均値で積分を近似するのがポイント。

- 確率分布 p(x) からサンプル X = [x_1, x_2, ..., x_N] を生成

- E[f] の近似として

を計算

PRML(パターン認識と機械学習)の19ページにも下のような記述がある。

ある関数 f(x) の確率分布 p(x) の下での平均値を f(x) の期待値(expectation)と呼び、E[f] と書く。離散分布に対しては

連続分布の場合は

どちらの場合も、確率分布や確率密度から得られた有限個のN点を用いて、期待値はこれらの点での有限和で近似できる。

サンプリング法について議論する際にこの結果を頻繁に使うことになる。

具体例で本当に成り立つか検証してみよう。Rによるモンテカルロ法入門では練習問題3.1で正規・コーシーベイズ推定量の積分を求めろという難しい例からいきなり始まるけれど自分で検算できるもっと簡単な積分から始めよう。

簡単な積分計算例

関数 f(x) の区間 [a, b] の以下の定積分をモンテカルロ法で求めてみよう。

この式は先の期待値を求める式と違って確率分布 p(x) が入っていない。入っていないなら入れてしまおう!区間 [a, b] の一様分布を p(x) とすると I は下のように変形できる。

上の式変形は間違い!正しい式変形は↓(コメント参照)

ここで、一様分布の [a, b] での定積分確率密度が 1/(b-a) であることを利用している。モンテカルロ積分のサンプル生成は与えられた区間の一様分布から生成することになる。手元の公式集の定積分の例をいくつか確かめてみよう。scipy.integrateで計算した場合と答えが一致することも確認しておいた。

(1)

# 任意の関数 f(x) の [a, b] での積分をモンテカルロ法で求める import numpy as np import matplotlib.pyplot as plt from scipy.stats import uniform import scipy.integrate a, b = -1, 1 f = lambda x: x ** 2 # 被積分関数をプロット x = np.linspace(-1.5, 1.5, 1000) y = f(x) plt.plot(x, y) # 積分範囲を色付け ix = arange(a, b, 0.001) iy = f(ix) verts = [(a, 0)] + list(zip(ix, iy)) + [(b,0)] poly = Polygon(verts, facecolor='0.8', edgecolor='k') gca().add_patch(poly) # scipy.integrateで積分を計算 I = scipy.integrate.quad(f, a, b)[0] print "scipy.integrate:", I # モンテカルロ積分 N = 100000 x = uniform(loc=a, scale=b-a).rvs(size=N) I = (b - a) * np.mean(f(x)) print u"モンテカルロ積分:", I

実行すると

scipy.integrate: 0.666666666667 モンテカルロ積分: 0.669414303329

(2)

a, b = 0, 1 f = lambda x: x * np.exp(x**2) # 以下同

scipy.integrate: 0.85914091423 モンテカルロ積分: 0.855417623185

(3)

a, b = 0, 1 f = lambda x: x**2 * np.exp(2*x) # 以下同

scipy.integrate: 1.59726402473 モンテカルロ積分: 1.60222532927

(4)

a, b = 1, np.exp(1) f = lambda x: np.log(x) / x # 以下同

scipy.integrate: 0.5 モンテカルロ積分: 0.499921834232

(5)

a, b = 1, 2 f = lambda x: x**3 * np.log(x) # 以下同

scipy.integrate: 1.83508872224 モンテカルロ積分: 1.8328253236

(6)

a, b = np.exp(1), np.exp(2) f = lambda x: np.log(x) ** 2 # 以下同

scipy.integrate: 12.0598303694 モンテカルロ積分: 12.0453421225

scipy.integrateに比べると少し近似精度が落ちるが積分が計算できていることがわかる。サンプル数Nを増やすと近似精度が増すこともわかる。

数値積分のアルゴリズムには、台形公式、シンプソン法、ガウス求積法などがある。scipy.integrateの実装を調べてみたが、QUADPACKに実装されているガウス求積法を使っているようだ。

実際のところ今回実験したような関数ではscipy.integrateの方が精度が高く、モンテカルロ積分を使う利点があまり感じられなかった。モンテカルロ法の利点は何なのだろう?従来のアルゴリズムの詳細を理解していないので完全に受け売りだが、モンテカルロ積分は統計や機械学習で頻繁に扱う多重積分においてより効率的とのこと。多重積分はあとで出てくるのかな?

次回はRによるモンテカルロ法入門の練習問題3.1の正規・コーシーベイズ推定量の積分を計算してみたい。複雑なのでビビるがけっこう簡単に求まる。

受理・棄却法 (4)

Pythonによるモンテカルロ法入門(2014/6/20)の受理・棄却法(2014/7/12)4回目。今回は練習問題2.18を解いてみた。下のような〜分布という名前がついていない完全に任意な目標分布にしたがう乱数を受理・棄却法で生成してみよう。

提案分布には標準正規分布を使う。

目標分布の式が示すように左辺は右辺に「比例する」だけで、積分が1になるように正規化されていない。乱数を生成するだけなら正規化は必須でないが、今回は最初から正規化しておいた。正規化するには右辺を全区間で積分した値でを割ればよい。Pythonで定積分を計算するには、scipy.integrate.quadが使える。

さっそく実装してみよう。

# 任意の確率分布にしたがう乱数を受理・棄却法で生成する import numpy as np import matplotlib.pyplot as plt import scipy.optimize import scipy.integrate from scipy.stats import norm np.random.seed() # 正規化前の目標分布f f = lambda x: np.exp(-x**2 / 2) * (np.sin(6*x)**2 + 3 * np.cos(x)**2 * np.sin(4*x)**2 + 1) # 正規化定数 I = scipy.integrate.quad(f, -Inf, Inf)[0] # 正規化済み(積分が1)の目標分布 f = lambda x: np.exp(-x**2 / 2) * (np.sin(6*x)**2 + 3 * np.cos(x)**2 * np.sin(4*x)**2 + 1) / I # 提案分布g gv = norm(loc=0.0, scale=1.0) g = gv.pdf # 分布の上限を指定する定数Mを設定 xopt = scipy.optimize.fmin(lambda x: - f(x) / g(x), 0.0, disp=False)[0] # そこでの値をMとする M = f(xopt) / g(xopt) print "M =", M # 受理・棄却法 Nsim = 100000 # 提案分布gからの乱数Yを生成 Y = gv.rvs(size=Nsim) # 一様乱数UをNsim個生成 U = uniform.rvs(size=Nsim) # Yから受理の条件を満たすサンプルXを残して残りを棄却 X = Y[U <= f(Y) / (M * g(Y))] print u"サンプル数: %d => %d" % (len(Y), len(X)) print u"実際の受理率 : %f" % (len(X) / float(len(Y))) print u"理論的な受理率: %f" % (1.0 / M) # 目標分布を描画 x = np.linspace(-10, 10, 1000) y = f(x) plt.plot(x, y, 'r-', lw=2) # 提案分布を描画 y = M * g(x) plt.plot(x, y, 'g-', lw=2) # 受理した乱数の分布を描画 plt.hist(X, bins=50, normed=True) plt.xlim((-5, 5)) plt.show()

実行すると

M = 1.85606973547 サンプル数: 100000 => 53818 実際の受理率 : 0.538180 理論的な受理率: 0.538773

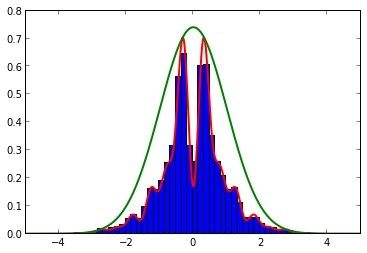

赤色が目標分布。緑色が提案分布

の正規分布。青色が受理されたサンプルのヒストグラム。ヒストグラムは赤色の理論値と一致していることがわかる。

少し気になってたのだけれど、どんな分布でも理論的な受理率が

で計算できてしまうのが不思議に感じてきた。もう少し理論的な背景も調べた方がよさそうだな。

今回で受理・棄却法はおしまい。次回から第3章のモンテカルロ積分にいく予定。乱数生成で難しい積分が効率的に計算できてしまうのだ!